原创 英伟达Rubin平台量产:整合6款全新芯片,推理Token成本降低10倍

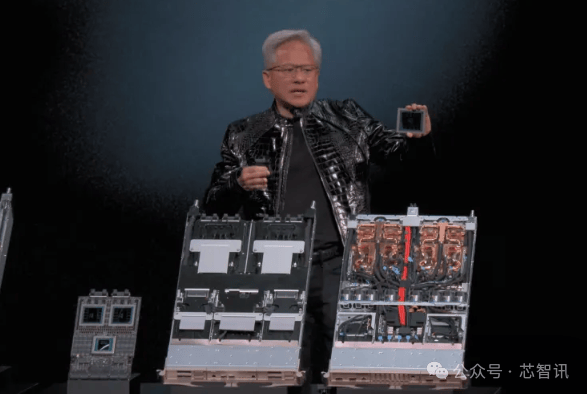

1月6日,英伟达(NVIDIA)首席执行官黄仁勋在CES2026展会发表主题演讲,正式推出最新的英伟达Rubin平台,并表示“已全面投入量产”。

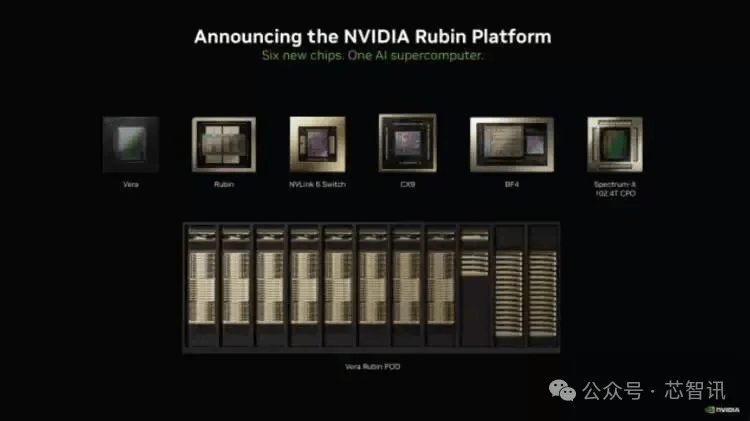

Rubin平台由6款全新芯片组成,涵盖Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU及Spectrum-6以太网交换机的极致协同设计,整合为一台性能惊人的AI超级计算机,可以大幅缩短AI训练时间并降低推理Token生成成本。目前,这六款芯片已从合作制造方处回厂,并通过部分关键测试,整体进度正按计划推进。

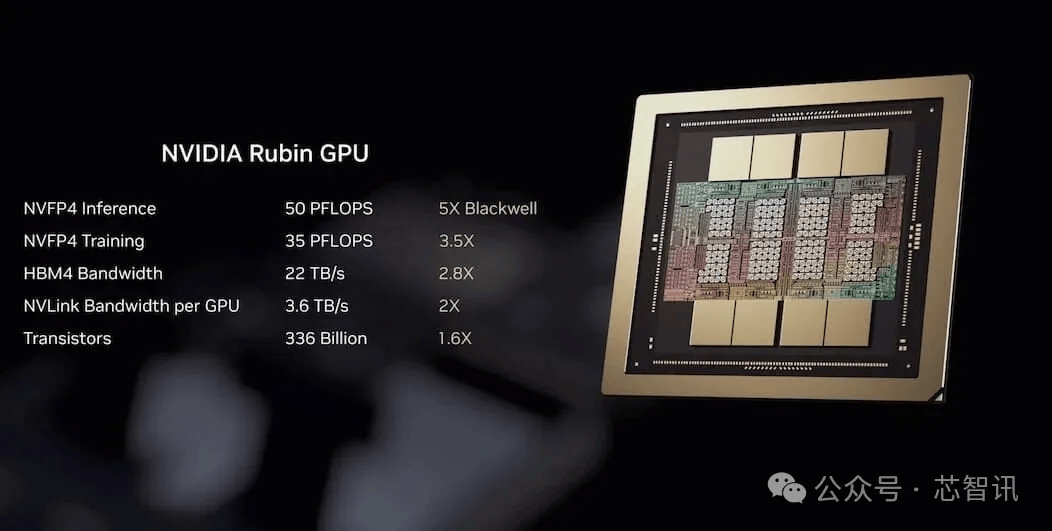

据英伟达公布的数据,Rubin平台的训练性能达到前代Blackwell的3.5倍,运行AI软件的性能提升5倍。此外,其推理每个代币(Token)生成成本相较于英伟达Blackwell平台可降低多达10倍,与前一代相比,英伟达Rubin平台在训练MoE模型时所需的GPU数量减少至原来的四分之一,进一步推动人工智能的普及应用。

具体来说,Rubin平台带来了五项关键创新,包括最新一代的英伟达NVLink互连技术、Transformer引擎、机密计算(Confidential Computing)与RAS引擎,以及英伟达Vera CPU。这些突破将加速代理式人工智能、高级推理能力和超大规模混合专家(MoE)模型的推理。

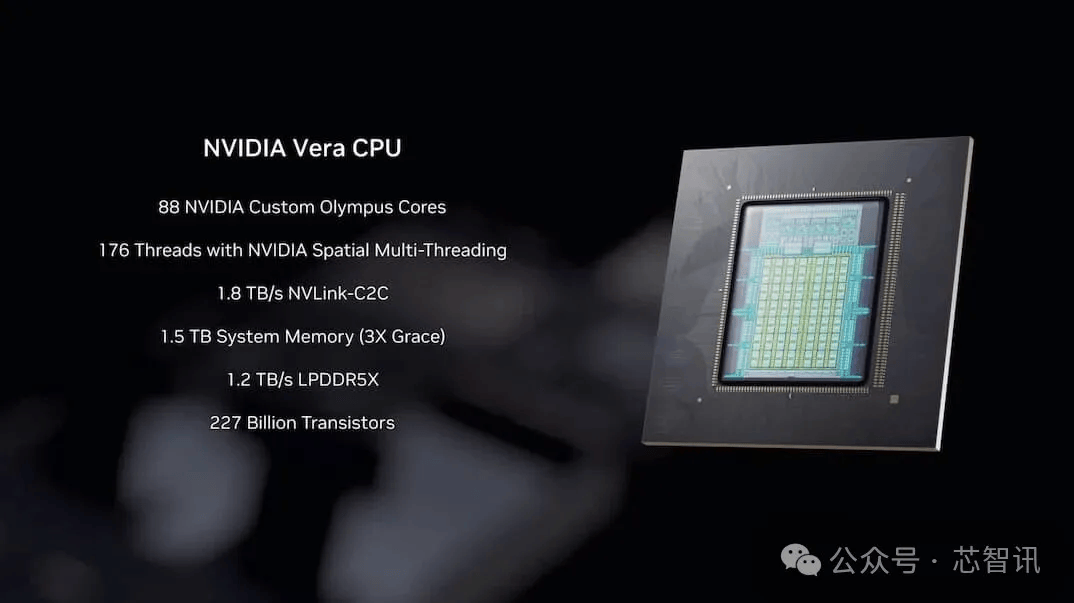

新一代Vera CPU基于新一代Armv9.2架构的定制化核心(代号Olympus),专为代理推理设计,总共集成了88个核心、176线程(支持英伟达空间多线程技术),配备1.8 TB/s NVLink-C2C一致性内存互联通道,支持1.5 TB系统内存(为Grace平台的3倍),通过SOCAMM LPDDR5X实现1.2 TB/s内存带宽,并具备机架级机密计算能力。这些特性共同带来相较于Grace平台2倍的数据处理、压缩及CI/CD性能提升。

Rubin GPU集成第三代Transformer引擎,具备硬件加速自适应压缩功能,可为AI推理提供50 petaflops的NVFP4算力。每个GPU带宽达3.6TB/s,而Vera Rubin NVL72机架的整体带宽更提升至260TB/s。

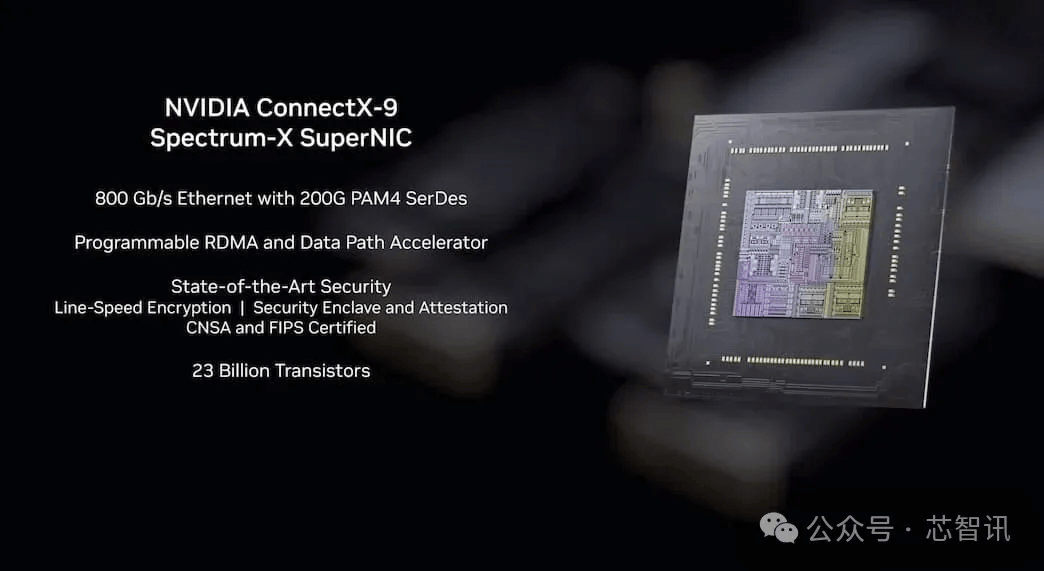

ConnectX-9 SuperNIC通过InfiniBand和以太网支持每端口800Gb/s的速度,为千兆级人工智能计算工作负载提供强大支持。它提供了极其快速、高效的网络连接,显著提升了人工智能工厂和云平台的系统性能。

强大的网络连接助力 NVIDIA ConnectX-9 SuperNIC 推动加速、千兆级人工智能计算架构的下一波创新。ConnectX-9 SuperNICs 与下一代 NVIDIA Spectrum-X 以太网和 NVIDIA Quantum-X800 网络平台无缝集成,为 NVIDIA Rubin GPU 提供高达每秒 1.6 Tb/s 的吞吐量。

这些平台提供了万亿参数GPU计算、分解服务架构和代理式人工智能应用所需的稳健性、功能集和可扩展性。凭借增强的能效,ConnectX-9 SuperNIC支持创建运营数十万台GPU的可持续人工智能数据中心,确保为人工智能的发展提供面向未来的基础设施。

ConnectX-9 SuperNIC还可提供增强的可编程输入/输出(IO)和基于遥测的拥塞控制功能,实现了业界领先的网络性能和峰值人工智能(AI)工作负载效率。此外,ConnectX-9 InfiniBand SuperNIC扩展了NVIDIA可扩展分层聚合与归约协议(SHARP)™的功能,以增强NVIDIA在高性能计算环境中的网络内计算能力,从而进一步提升科学计算工作负载、大规模训练和推理的整体效率和性能。

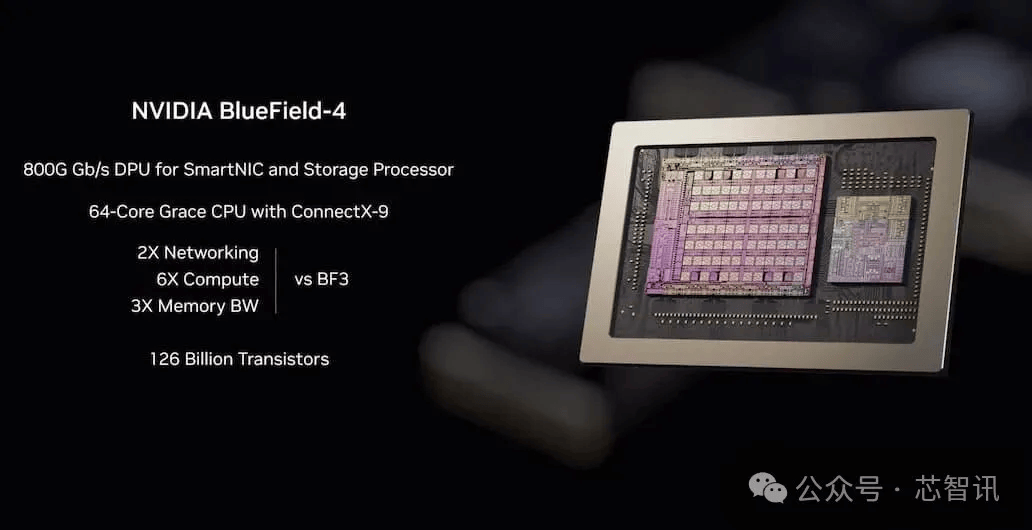

NVIDIA BlueField-4一款专为千兆级推理打造的新型人工智能原生存储基础设施所需的800G DPU,可助力智能体人工智能的加速与扩展。其整合了64核心的Grace CPU和ConnectX-9 SuperNIC,相比BlueField-3实现2倍网络传输能力、6倍计算性能与3倍内存带宽提升。据介绍,英伟达推理上下文内存存储平台通过扩展GPU内存容量,构建起上下文内存支撑架构,实现节点间的高速数据共享。相较于传统存储方案,该平台可使每秒令牌处理量提升最高5倍,能效提升最高5倍。

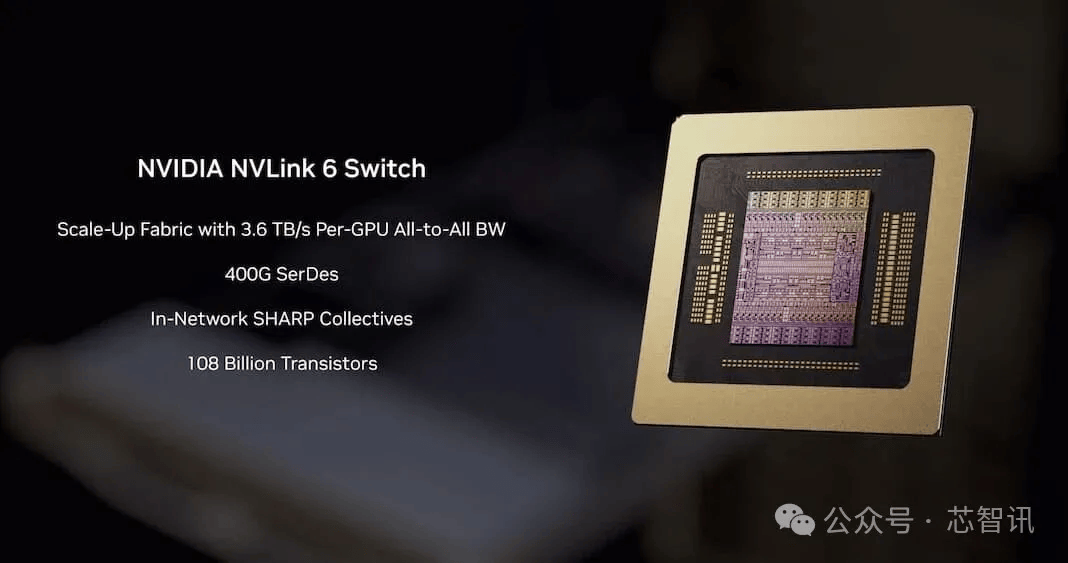

第六代NVLink交换机为Rubin平台提供网络架构,采用400G SerDes技术,每CPU支持3.6 TB/s全对全带宽,总带宽达28.8 TB/s,支持14.4 TFLOPS FP8网络内计算,并采用100%液冷设计方案。

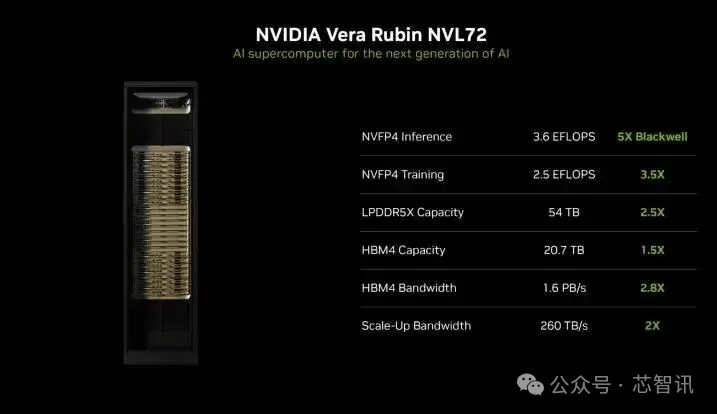

所有这些技术最终汇聚于英伟达Vera Rubin NVL72机架系统,集成了72颗英伟达Rubin GPU、36颗英伟达Vera CPU、英伟达NVLink 6、英伟达ConnectX-9 SuperNIC以及英伟达BlueField-4 DPU。相较Blackwell平台实现显著性能跃升。

具体数据如下:NVFP4推理性能提升5倍(达3.6 EFLOPS)、NVFP4训练性能提升3.5倍(达2.5 EFLOPS)、LPDDR5x内存容量提升2.5倍(达54 TB)、HBM4显存容量提升1.5倍(达20.7 TB)、HBM4显存带宽提升2.8倍(达1.6 PB/s)、纵向扩展带宽提升2倍(达260 TB/s)。

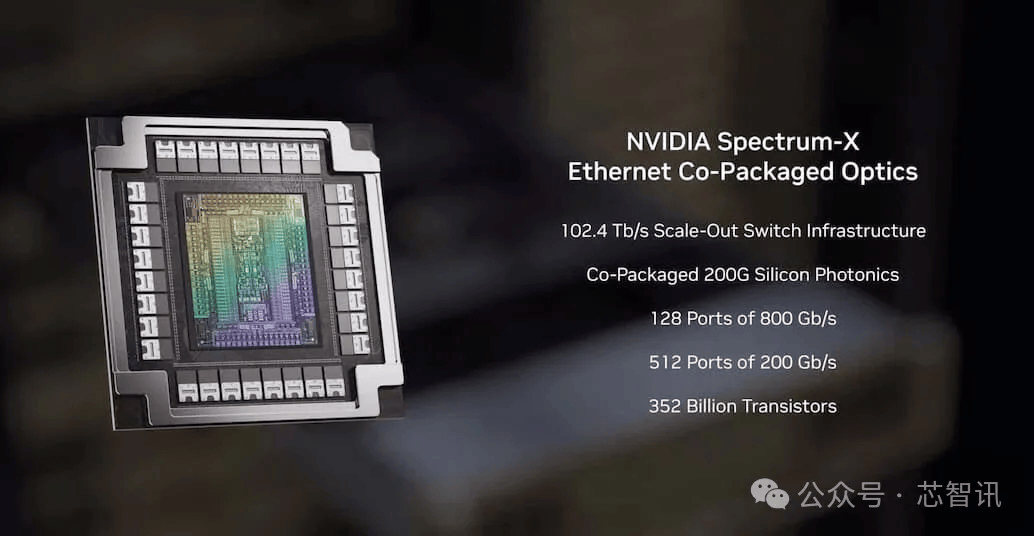

英伟达同时还发布Spectrum-X以太网共封装光学解决方案,提供102.4 Tb/s横向扩展交换架构,集成200G硅光共封装技术,在大规模部署中可实现95%的有效带宽利用率。该系统能效提升5倍,可靠性增强10倍,应用程序运行效率提高5倍。

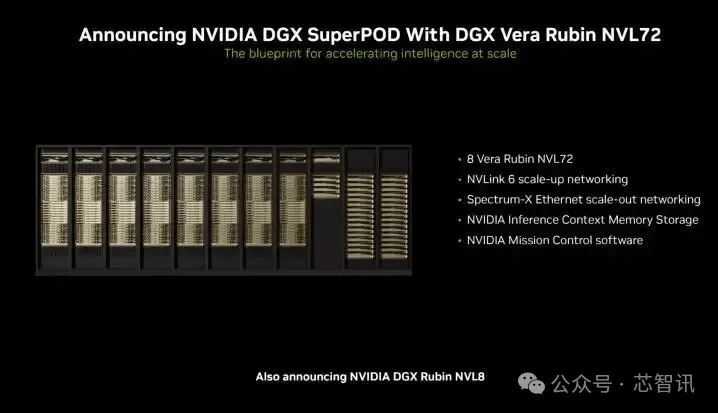

此外,英伟达还推出了NVIDIA DGX SuperPOD™作为大规模部署Rubin系统的参考架构,集成了NVIDIA DGX Vera Rubin NVL72或DGX Rubin NVL8系统,并搭配了NVIDIA BlueField-4 DPU、NVIDIA ConnectX-9 SuperNIC、NVIDIA InfiniBand网络以及NVIDIA Mission Control软件。

此外,针对主流数据中心市场,英伟达还将推出NVIDIA DGX Rubin NVL8配置方案。这是一款通过NVLink连接8颗Rubin GPU的服务器主板,用于支持基于x86的生成式AI平台。HGX Rubin NVL8平台可加速AI与高性能计算(HPC)工作负载的训练、推理及科学计算。

英伟达透露,包括亚马逊AWS、谷歌云、微软Azure和甲骨文云在内的多家云服务商将于2026年率先部署基于Vera Rubin的实例。此外,CoreWeave、Lambda、Nebius和Nscale等云合作伙伴也将陆续跟进。

编辑:芯智讯-浪客剑