KernelCAT 发布,Agent 自动化实现国产芯片适配与计算加速

国产算力基建进入下半场,重心正从芯片的「数量增长」转向「效率提升」。国产芯片数量持续增长,但生态建设依旧落后,这正是当下 AI 落地最真实的一幕。

模型不断刷新参数,底层却在艰难转场。

比起轮番刷新的参数规模记录,更难转变的是开发者所使用的那套固化的流程。算力只是门槛,而真正的较量在于算法与硬件的协同效率。

KernelCAT:计算加速专家级别的 Agent

几乎每个人都能感受到 AI 领域的加速感,模型密集发布,应用数据持续走高。但在真实的工程现场,感受却更复杂:真正制约落地效率的不是模型能力本身,而是底层软件生态的成熟度。

硬件选择变多,问题反而集中暴露出来:迁移成本高,适配周期长,性能释放不稳定。很多模型即便具备条件切换算力平台,最终也会被算子支持和工具链完整度挡在门外。

这让一个事实变得越来越清晰。突破口不是堆更多算力,而是打通算法到硬件之间那段最容易被忽视的工程链路,把芯片的理论性能真正转化为可用性能。

其中最关键的一环正是高性能算子的开发。

算子(Kernel)的作用是连接 AI 算法与计算芯片,它将算法转化为硬件可执行的指令,决定了 AI 模型的推理速度、能耗与兼容性。

算子开发属于内核级的编程工程,但行业现状却仍高度依赖个人经验。它极度依赖顶尖专家的直觉与肌肉记忆,性能调优往往像是在迷雾里盲测,周期漫长。

但如果,让 AI 来开发算子呢?

传统大模型或知识增强型 Agent 在此类任务面前往往力不从心。因为它们擅长模式匹配,却难以理解复杂计算任务中的物理约束、内存布局与并行调度逻辑。唯有超越经验式推理,深入建模问题本质,才能实现真正的「智能级」优化。

正是在这种严峻的技术挑战下,KernelCAT 应运而生。

KernelCAT 终端版 Agent

KernelCAT 是一款本地运行的 AI Agent。它不仅是深耕算子开发和模型迁移的「计算加速专家」,也能够胜任日常通用的全栈开发任务,提供了 CLI 终端命令行版与简洁桌面版两种形态供开发者使用。

不同于仅聚焦特定任务的工具型 Agent,KernelCAT 具备扎实的通用编程能力。

它不仅能理解、生成和优化内核级别代码,也能处理常规软件工程任务,如环境配置、依赖管理、错误诊断与脚本编写,从而在复杂场景中实现端到端自主闭环。

KernelCAT 桌面版 Agent

为国产芯片生态写高性能算子

在算子开发中,有一类问题很像「调参」。面对几十上百种参数或策略组合,工程师需要找出让算子跑得最快的那一组配置。

传统做法靠经验试错费时费力且容易踩坑。KernelCAT 的思路是:引入运筹优化,把「找最优参数」这件事交给算法,让算法去探索调优空间并收敛到最佳方案。

以昇腾芯片上的 FlashAttentionScore 算子为例,KernelCAT 可以依据昇腾官方的示例代码自动对该算子的分块参数调优问题进行运筹学建模,并使用数学优化算法求解。十几轮迭代后就能锁定最优配置,在多种输入尺寸下延迟降低最高可达 22%,吞吐量提升最高近 30%,整个过程无需人工干预。

这正是 KernelCAT 的独特之处。它不仅具备大模型的智能,能够理解代码、生成方案,还拥有运筹优化算法的严谨,能够系统搜索并收敛到最优解。

智能与算法的结合让算子调优既灵活,又有交付保障。

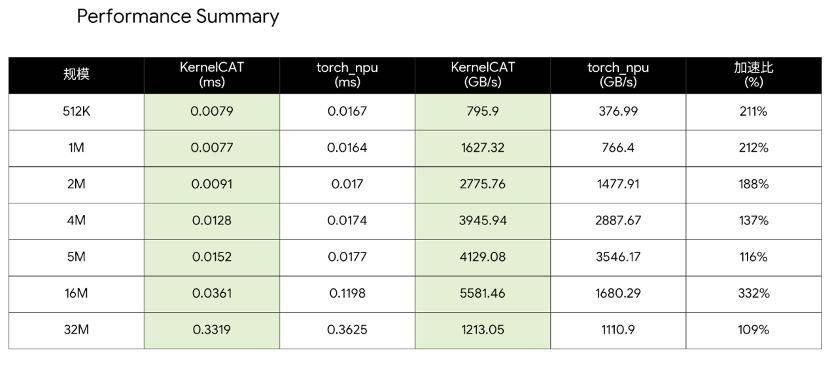

在对 KernelCAT 的另一场测试中,该团队选取了 7 个不同规模的向量加法任务,测试目标明确,即在华为昇腾平台上,直接对比华为开源算子、「黑盒」封装的商业化算子与 KernelCAT 自研算子实现的执行效率。

结果同样令人振奋。在这个案例的 7 个测试规模中,KernelCAT 给出的算子版本性能均取得领先优势,且任务完成仅用时 10 分钟。这意味着,即便面对经过商业级调优的闭源实现,KernelCAT 所采用的优化方式仍具备一定竞争力。

这不仅是数值层面的胜利,更是国产 AI Agent 在算子领域完成的一次自证。

没有坚不可破的生态,包括 CUDA

全球范围内,目前超过 90% 的重要 AI 训练任务运行于英伟达 GPU 之上,推理占比亦达 80% 以上;其开发者生态覆盖超 590 万用户,算子库规模逾 400 个,深度嵌入 90% 顶级 AI 学术论文的实现流程。

黄仁勋曾言:「我们创立英伟达,是为了加速软件,芯片设计反而是次要的。」

在现代计算体系中,软件才是真正的护城河。英伟达的持续领先,源于其从底层算法出发、贯通架构与编程模型的全栈掌控能力。

参考 AMD 的历史经验,即使在架构与制程上具备充足的竞争力,缺乏成熟的生态系统也仍然难以撼动英伟达的地位。

这类案例清晰地表明,模型性能并不简单等价于算力规模的堆叠,而是取决于算法设计、算子实现与硬件特性的协同程度。当算子足够成熟,硬件潜力才能被真正释放。

沿着这条思路,KernelCAT 团队围绕模型在本土算力平台上的高效迁移,进行了系统性的工程探索。以 DeepSeek-OCR-2 模型在华为昇腾 910B2 NPU 上的部署为例,KernelCAT 展示了一种全新的工作范式:

实现 35 倍加速:在引入 vllm-ascend 原生 MOE 实现补丁后,vLLM 在高并发下的吞吐量飙升至 550.45toks/s,相比 Transformers 方案实现了 35 倍加速,且在继续优化中。

无需人工大量介入:在这种复杂任务目标下,KernelCAT 可以自己规划和完成任务,无需研发提供大量提示词指导模型工作。

有了 KernelCAT,原本需要顶尖工程师团队花费数周才能完成进行的适配工作,现在可以缩短至小时级(包含模型下载、环境构建的时间)。

与此同时,它让国产芯片实现了 35 倍的加速。也就是说,KernelCAT 让国产芯片可以通过深度工程优化,承载顶级多模态模型推理任务的性能引擎。

KernelCAT 所代表的不只是一个 AI Agent 新范式的出现,更是一种底层能力建设方式的转向:从依赖既有生态,到构建能够自我演进的计算基础。

KernelCAT 正限时免费内测中,欢迎体验。