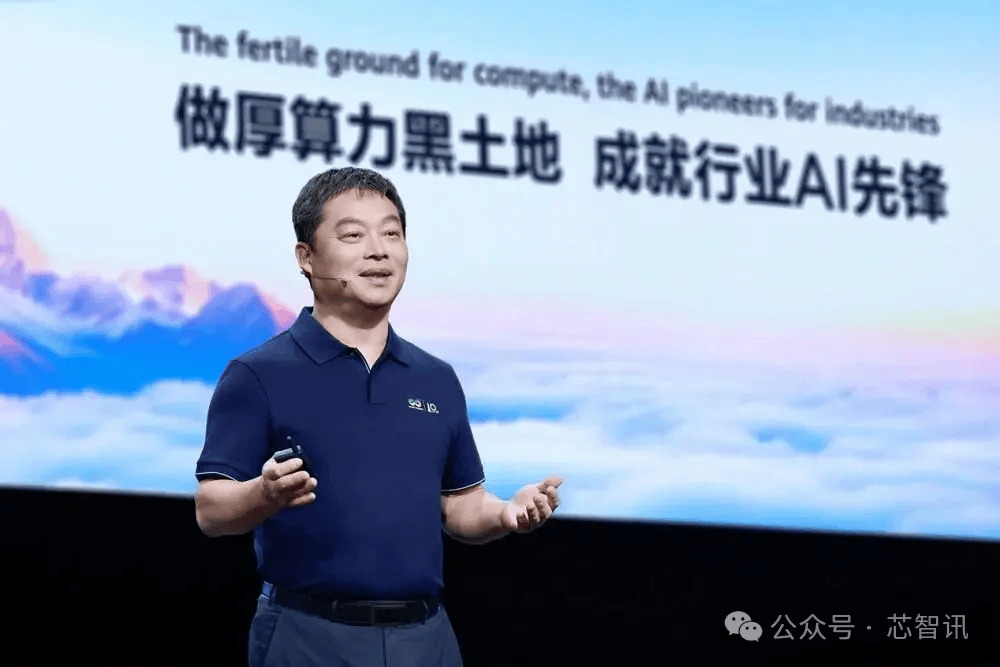

张平安:芯片制程并非核心,华为算力效能已超英伟达3倍!

10月4日消息,华为常务董事、华为云CEO张平安近日对外表示,华为云服务在算力效能方面实现突破,其生产效率已达到英伟达H20芯片的3倍。对此,张平安指出,芯片制程并非核心,客户真正需要的是优质的计算结果。

技术创新:架构革命打破冯·诺依曼桎梏

“芯片制程并非核心,客户真正需要的是优质的计算结果。”张平安的这句话直指算力竞争的本质。华为云的效能突破,始于对传统计算架构的颠覆式创新。在WAIC展台上备受瞩目的CloudMatrix384超节点,其核心价值在于突破了延续半个多世纪的冯·诺依曼架构局限,构建起“对等计算架构”的全新范式。

传统架构中CPU作为“中心枢纽”的主从式依赖关系,在千亿参数大模型时代导致严重的算力闲置。而华为云通过分布式资源调度协议,让CPU、AI芯片、内存等组件形成平等协作的“算力网络”,每个节点可根据任务需求动态获取资源。配合自研的智能互联总线协议,实现全域内存统一编址与直接访问,如同为不同设备打通“共享走廊”,数据无需多层协议转换即可自由流动。这种“对等架构+总线技术+通信优化”的三位一体创新,使得CloudMatrix384在50毫秒时延下实现单卡每秒2400个token的生成能力,平均推理性能达到H20的3至4倍。

硬件创新之外,华为云的软件定义能力同样关键。EMS弹性内存存储服务通过内存扩展显存,显著降低大模型多轮对话时延;GaussDB数据库基于计算、内存、存储分层池化,实现每分钟540万笔事务处理,性能提升2.9倍。这种软硬协同的系统工程思维,正是其技术自信的核心密码。

生态开放:从“独善其身”到“共筑繁荣”

算力效能的领先若缺乏生态支撑,终将沦为孤立的技术参数。华为云的第二重自信,来自其“所有大模型在昇腾云上都能跑得更快、更好”的开放承诺。这种开放不仅体现在模型适配的广度上,更构建了从底层硬件到上层应用的全栈生态体系。

在模型层,昇腾云服务既坚定聚焦盘古大模型的行业深耕,又通过openPangu开源社区为开发者提供最佳实践。目前已全面支持DeepSeek、Kimi等第三方模型,形成闭源与开源并行的双轨策略。ModelArts一站式AI开发平台沉淀行业Know-how,提供数据配比、模型增训、效果评测的全流程工具链;DataArts数据治理生产线则构建企业统一知识湖,为大模型训练提供高质量语料。这种“模型+工具+数据”的生态闭环,让开发者门槛大幅降低。

“我们希望所有大模型在昇腾云上都能跑得更快、更好。”张平安表示。

客户增长的数据印证了生态的吸引力:使用华为云AI服务的全球客户从去年的321家激增至1805家。360纳米AI依托Token推理服务日处理上千万内容生成请求,中国科学院“磐石·科学基础大模型”赋能百余个院所科研场景,南方航空通过盘古跨模态预测实现90%准确率的客流票价预测。正如张平安所言,华为云要做的是算力“黑土地”,让千行万业的智能化应用在此蓬勃生长。

战略纵深:基础设施与未来布局的双重保障

短期的技术领先可能被超越,长期的战略布局才是持久自信的来源。华为云的第三重底气,在于其对算力基础设施和未来技术趋势的前瞻性投入。

在基础设施层面,华为云已在贵州、内蒙古、安徽部署全液冷AI数据中心,实现单机柜80千瓦散热,PUE低至1.1,未来更将把超节点规格从384卡升级至8192卡,构建50至100万卡的超大集群。这种“云边端”协同的分布式云解决方案,已在一汽大众五地六工厂实现数据无缝流动,为智能制造提供坚实底座。

张平安指出,中国的“算力黑土地”正在逐步成为全球客户的AI算力中心。华为在海外布局时发现,尽管中国国内的智能计算中心均采用液冷技术,但海外液冷数据中心仍较为罕见。若要对海外数据中心进行改造,不仅耗时较长,而且光纤网络带宽也难以满足需求。

张平安最后强调,根据规定,每个云厂商一旦发生重大事故都需在网上公开披露,而华为云已连续756天保持重大事故“零记录”。“我们有信心将这一成果持续保持下去。”他说。

相关文章:《华为昇腾AI芯片路线图公布!》

编辑:芯智讯-林子